Résumé – Confrontées à la volatilité des prix, aux objectifs bas carbone et aux exigences du AI Act, les entreprises énergétiques doivent garantir sécurité, robustesse et traçabilité de leurs modèles IA dès la conception. L’architecture modulaire en micro-services auditables, soutenue par des pipelines ML reproductibles, un middleware SI adaptable et l’adoption de briques open source, permet de tester, monitorer et expliciter chaque composant selon son niveau de criticité.

Solution : déployer un écosystème de micro-services isolés, coupler MLOps et gouvernance data stricte, et segmenter les modèles par criticité pour innover en toute conformité.

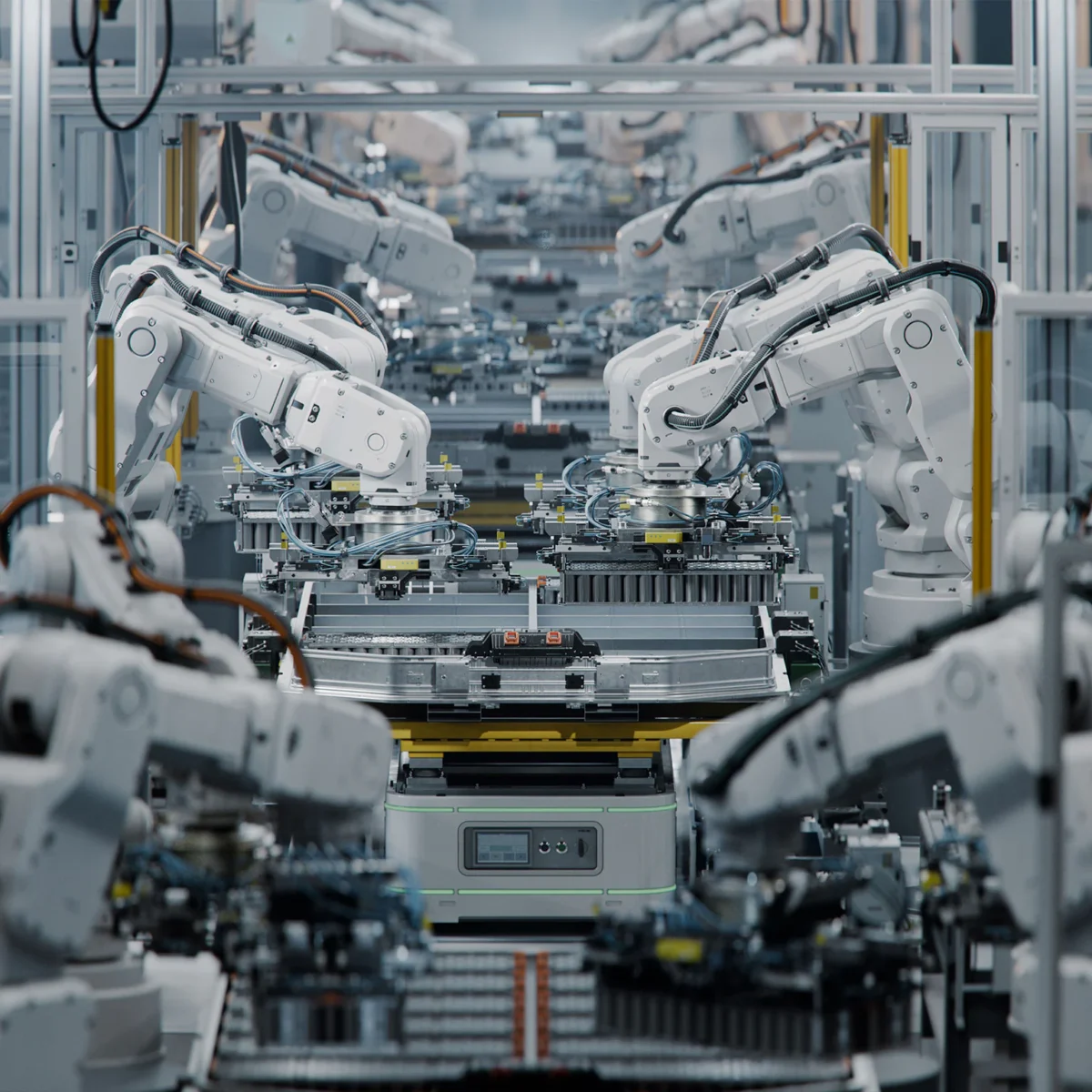

L’essor de l’IA révolutionne le secteur énergétique, en offrant des capacités avancées de prévision de charge, d’optimisation des réseaux, de maintenance prédictive et d’automatisation des interactions clients. Ces innovations, essentielles pour relever les défis liés à la volatilité des prix et aux objectifs de transition bas carbone, sont désormais encadrées par l’AI Act de l’UE. Les entreprises doivent intégrer la conformité dès la conception pour garantir la sécurité, la robustesse et l’explicabilité de leurs modèles, notamment dans des environnements critiques.

Au-delà d’une simple analyse réglementaire, cet article détaille comment une architecture logicielle modulaire et auditable, enrichie de pipelines ML et de composants open source, permet d’innover sans prendre de risques. Vous y découvrirez des solutions sur mesure pour les cas d’usage sensibles, des stratégies d’intégration SI et de middleware flexibles, l’adoption de briques open source pour éviter le vendor lock-in, puis une gouvernance data et des modèles multi-niveaux adaptés aux différents niveaux de criticité.

Architecture modulaire et solutions sur mesure

L’architecture logicielle must-have doit segmenter chaque fonctionnalité IA critique en micro-services autonomes. Chaque brique dispose de protocoles d’audit et de traçabilité intégrés pour répondre aux exigences du EU AI Act.

Conception modulaire pour les usages critiques

La segmentation des fonctionnalités IA en modules indépendants permet de limiter la surface d’impact en cas de faille ou de mise à jour. Les micro-services dédiés au pilotage réseau ou à la stabilisation de flux peuvent être isolés du reste de la plateforme, garantissant une disponibilité continue des autres services.

Cette approche facilite également l’application de mesures de sécurité ciblées, telles que le chiffrement des données en transit et des contrôles d’accès granulaires. Les équipes peuvent ainsi déployer et mettre à l’échelle chaque composant sans perturber l’ensemble de l’écosystème.

Par exemple, une entreprise du secteur hydroélectrique a développé un micro-service dédié à la stabilisation de crêtes de production. Cette isolation a permis de démontrer une réduction de 40 % du temps moyen de réponse aux alertes critiques, tout en conservant les autres systèmes en service.

Audits automatisés et traçabilité continue

Chaque interaction entre modules IA est enregistrée dans des journaux normalisés, retraçant l’historique des données et des décisions. Cette traçabilité est cruciale pour répondre aux obligations d’explicabilité et garantir la transparence des algorithmes.

Des outils d’audit automatisé peuvent analyser ces journaux, générer des rapports et identifier les anomalies ou écarts vis-à-vis des exigences réglementaires. Les équipes de conformité disposent ainsi d’un tableau de bord en temps réel pour surveiller l’application des bonnes pratiques.

La mise en place de contrôles unitaires et de tests d’intégration spécifiques aux micro-services permet de valider, avant déploiement, que chaque modification respecte les seuils de performance et de sécurité définis par le AI Act. Les audits automatisés assurent ainsi une conformité continue sans freiner le rythme d’innovation.

Tests et validation dans des environnements simulés

Avant toute mise en production, les modules IA critiques sont testés dans des environnements virtuels reproduisant les conditions réelles d’exploitation. Ces bancs de test intègrent des flux SCADA et des jeux de données historiques pour simuler des scénarios de pointe.

Les campagnes de tests de bout en bout valident la robustesse des modèles face à des perturbations volumétriques et des anomalies. Elles mesurent les performances, la latence et la résilience des micro-services, tout en vérifiant la conformité aux exigences d’explicabilité.

Ce processus de validation structurel réduit significativement les risques de régression et assure que seules des versions validées, auditables et documentées accèdent aux environnements de production critiques.

Intégration SI et middleware flexibles

Relier l’IA aux systèmes existants exige un middleware adaptable, capable de standardiser les flux entre SCADA, ERP, plateformes IoT et jumeaux numériques. L’objectif est de garantir la cohérence, la sécurité et l’auditabilité de chaque échange.

Connecteurs adaptatifs pour SCADA et ERP

Les connecteurs doivent s’appuyer sur des API REST ou sur des bus de messages pour assurer la transmission bidirectionnelle des données en temps réel. Chaque mastering de version et chaque schéma de données sont versionnés pour garantir la traçabilité.

Des adaptateurs peuvent transformer les protocoles propriétaires de SCADA en flux standardisés, tout en appliquant des filtres et des logiques de contrôle d’accès. Cette couche d’abstraction facilite la mise à jour des systèmes sans impacter le cœur IA.

La normalisation des événements garantit que chaque donnée sensée alimenter un modèle IA respecte les contraintes de format et de qualité définies par la gouvernance data. Le schéma centralisé facilite les audits réglementaires et sécurise les échanges.

Plateformes IoT et jumeaux numériques intégrés

Les capteurs IoT et les jumeaux numériques fournissent une source continue de données pour la maintenance prédictive et l’optimisation de la consommation. L’intégration passe par un bus de données ou un broker MQTT renforcé par du TLS et une gestion de certificats.

Les données collectées sont filtrées, enrichies et étiquetées avant d’alimenter les pipelines ML. Ces processus de prétraitement sont documentés et audités, garantissant qu’aucune donnée sensible n’est traitée en dehors des périmètres autorisés.

Une entreprise de services publics a relié un jumeau numérique à ses modules d’analyse prédictive. Cet exemple démontre comment un middleware bien architecturé assure la cohérence des données entre la simulation et le terrain, tout en respectant les contraintes de sécurité imposées par le EU AI Act.

Orchestration et mise à l’échelle indépendantes

Les workflows d’IA sont orchestrés via des pipelines conteneurisés, déployables sur Kubernetes ou des plateformes serverless. Chaque service est supervisé, scalé et isolé selon des politiques de niveau de criticité.

Ces orchestrateurs intègrent des contrôles de conformité en continu, tels que des scans de vulnérabilités et des check-lists réglementaires avant chaque redéploiement. Les incidents sont remontés automatiquement vers les équipes DevOps et conformité.

Grâce à cette couche d’orchestration, les équipes garantissent que seules des versions validées et auditables des micro-services IA sont actives en production, réduisant les risques et accélérant les cycles de mise à jour.

Edana : partenaire digital stratégique en Suisse

Nous accompagnons les entreprises et les organisations dans leur transformation digitale

Composants open source et pratiques MLOps

L’adoption de briques open source offre transparence, liberté et mises à jour continues. Les pipelines MLOps standardisés assurent la reproductibilité, la traçabilité et l’auditabilité des modèles.

Briques open source pour chaque étape ML

Des frameworks comme Kubeflow, MLflow ou Airflow peuvent orchestrer l’entraînement, la validation et le déploiement des modèles. Leur code source ouvert facilite les audits et permet d’adapter les composants aux besoins spécifiques.

Ces outils offrent des fonctions natives de versioning des datasets, des modèles et des configurations. Chaque variation est stockée, horodatée et liée à son environnement d’exécution, garantissant une traçabilité complète.

Cette transparence contribue à répondre aux exigences de documentation du EU AI Act, notamment pour la partie explicabilité et pilotage des risques, tout en évitant de dépendre d’un fournisseur unique.

Monitoring et alerting proactifs

Le déploiement en production inclut un monitoring des indicateurs clés : dérive des données, performance des modèles, latence des prédictions et erreurs d’exécution. Ces métriques sont collectées via des outils open source comme Prometheus et Grafana.

Des alertes sont configurées pour notifier les équipes en cas de comportement anormal ou de non-conformité aux seuils réglementaires. Les tableaux de bord fournissent une vue consolidée des risques et facilitent les audits.

Ce suivi en continu permet d’anticiper la dégradation des modèles, d’ajuster les entrées data et de planifier des réentraînements, assurant ainsi une performance homogène et conforme sur le long terme.

Explicabilité et interprétabilité intégrées

Des bibliothèques comme SHAP ou LIME peuvent être intégrées dans les pipelines pour générer automatiquement des rapports d’explicabilité. Chaque prédiction critique est assortie d’une justification basée sur les attributs d’entrée et les poids du modèle.

Ces rapports sont horodatés et conservés dans un entrepôt de données auditable. Ils sont essentiels pour démontrer la non-discrimination, la robustesse et la transparence des systèmes, comme l’exige le AI Act.

Un fournisseur de réseaux thermiques a intégré SHAP dans son pipeline de maintenance prédictive. Cet exemple démontre comment l’explicabilité automatisée renforce la confiance des régulateurs et des parties prenantes sans ralentir le passage en production.

Gouvernance data, pipelines ML auditables et modèles multi-niveaux

Une gouvernance data structurée et des pipelines ML auditables garantissent la conformité, la robustesse et la reproductibilité des modèles. Le recours à des modèles multi-niveaux permet d’ajuster la criticité selon l’usage.

Charte data et catalogage des jeux

La gouvernance commence par une charte data définissant les rôles, responsabilités, classifications et procédures de gestion des données. Chaque dataset est catalogué, annoté selon sa criticité réglementaire et soumis à des contrôles qualité.

Les pipelines ingèrent ces jeux de données via des processus ETL versionnés et audités. Tout rejet ou déviation de schéma génère une alerte et un rapport, assurant que seules des données validées alimentent les modèles.

Cette rigueur garantit la conformité aux exigences de qualité et de traçabilité, et constitue la base d’un audit réussi devant les autorités compétentes.

Pipelines ML reproductibles et auditables

Les workflows MLOps structurés en étapes distinctes (prétraitement, entraînement, validation, déploiement) sont codés et stockés dans des dépôts versionnés. Les configurations et hyperparamètres sont déclarés dans des fichiers de version, assurant la reproductibilité.

Chaque exécution de pipeline génère un rapport de conformité, incluant les métriques de performance et les résultats des tests de robustesse. Ces artefacts sont conservés et consultables pour tout audit réglementaire.

Modèles multi-niveaux selon la criticité

Les cas d’usage à faible criticité, tels que la prévision de consommation ou la BI prédictive, peuvent reposer sur des modèles plus légers et des processus de validation allégés. Les exigences d’explicabilité restent présentes, mais la fréquence de réentraînement et les contrôles peuvent être ajustés.

Pour les modèles à haute criticité – contrôle en temps réel des installations, pilotage des micro-grids ou stabilisation secteur – la chaîne de validation est renforcée. Elle inclut des tests adversariaux, des simulations extrêmes et des rapatriements de logs détaillés pour chaque prédiction.

Cette segmentation par niveau de risque optimise les ressources, accélère le déploiement des innovations non critiques et assure une rigueur maximale là où la sécurité et la fiabilité sont impératives.

Optimiser l’innovation IA dans l’énergie en toute conformité

Une architecture logicielle modulaire, l’intégration SI agile, l’adoption de briques open source et une gouvernance data stricte permettent d’innover rapidement tout en respectant le EU AI Act. Les pipelines MLOps reproductibles, le monitoring proactif et l’explicabilité intégrée garantissent la traçabilité et la robustesse des modèles.

Les modèles multi-niveaux facilitent l’équilibre entre performance et criticité, offrant une réponse adaptée à chaque cas d’usage, de la prévision de charge aux systèmes de contrôle en temps réel. Cette approche globalement cadre l’innovation dans un périmètre sécurisé et auditable.

Nos experts en architecture logicielle, cybersécurité, IA et stratégie digitale sont à votre disposition pour évaluer vos besoins, concevoir un écosystème hybride et accompagner la mise en œuvre de solutions conformes et évolutives.

Lectures: 5

Lectures: 5